AWS上のWindows Server 2016で拡張ネットワーキングをONにして見たいと思います。

そもそも拡張ネットワーキングとは?

拡張ネットワーキングは、高い帯域幅、1 秒あたりのパケット (PPS) の高いパフォーマンス、常に低いインスタンス間レイテンシーを実現します。拡張ネットワーキングは追加料金なしで使用できます。

Linux の拡張ネットワーキング - Amazon Elastic Compute Cloud

ということです。

つまり有効にするだけで通信が早くなるというすぐれものです。

拡張ネットワーキングを有効にする手順

環境

- Windows Server 2016 Base

- m4.large

Intelネットワークドライバをインストールする

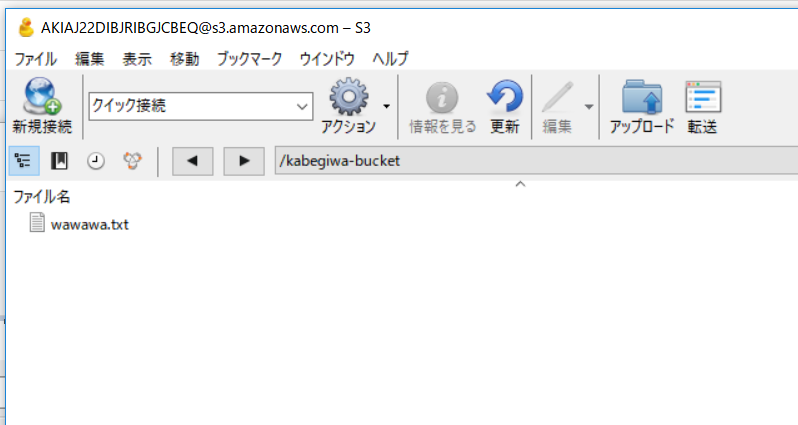

以下のURLからIntelネットワークアダプタドライバーをダウンロードします。

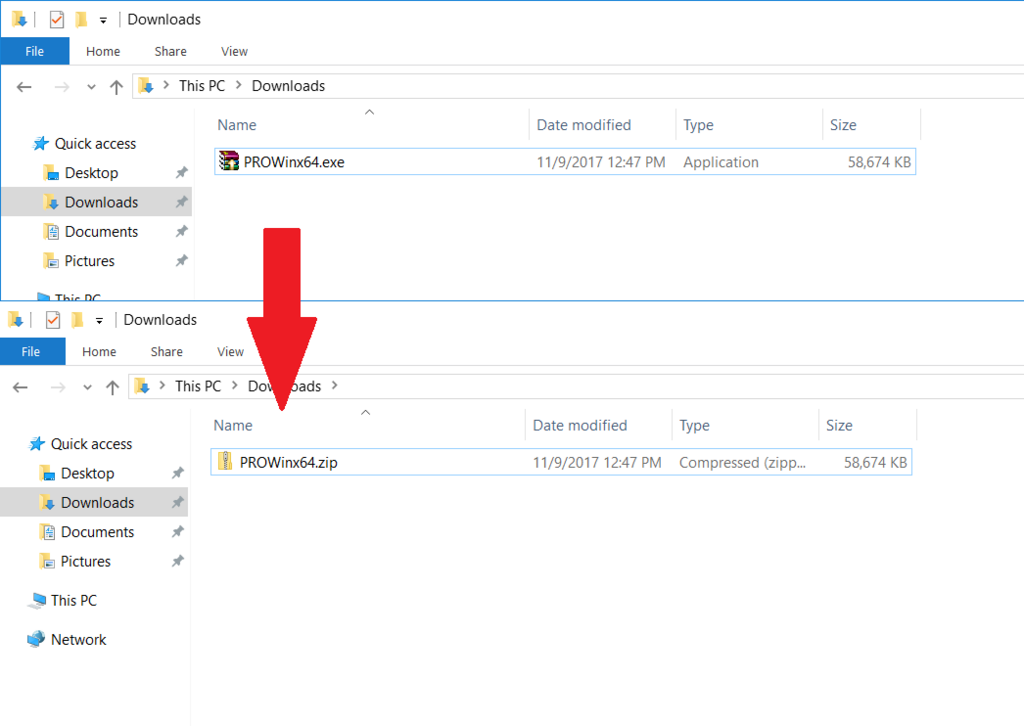

「ProWinx64.exe」というファイルがダウンロードされたかと思います。

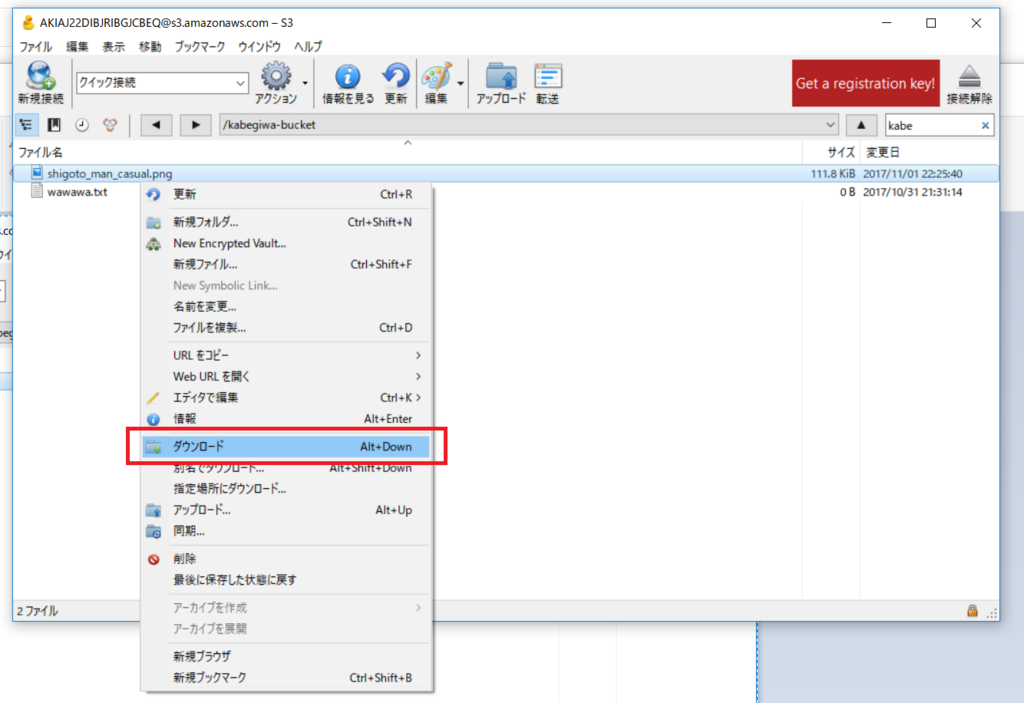

それを「ProWinx64.zip」に拡張子を変更します。

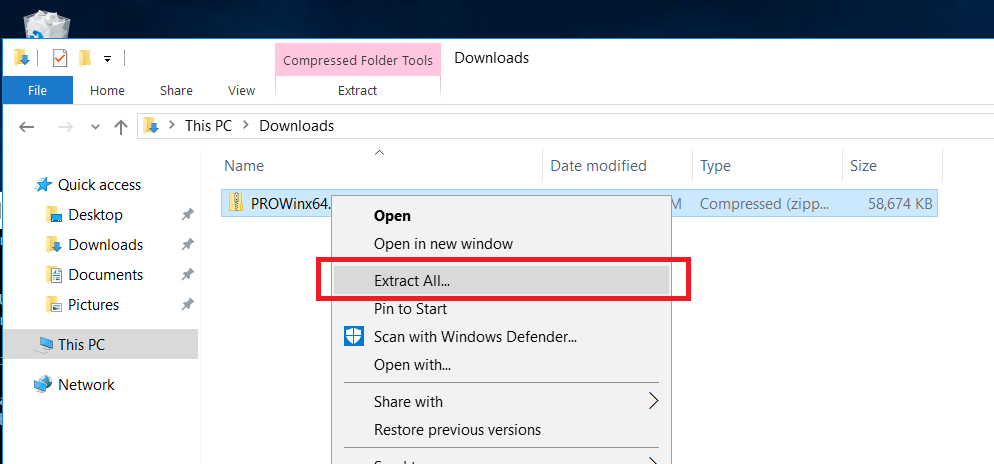

「ProWinx64.zip」を展開します。

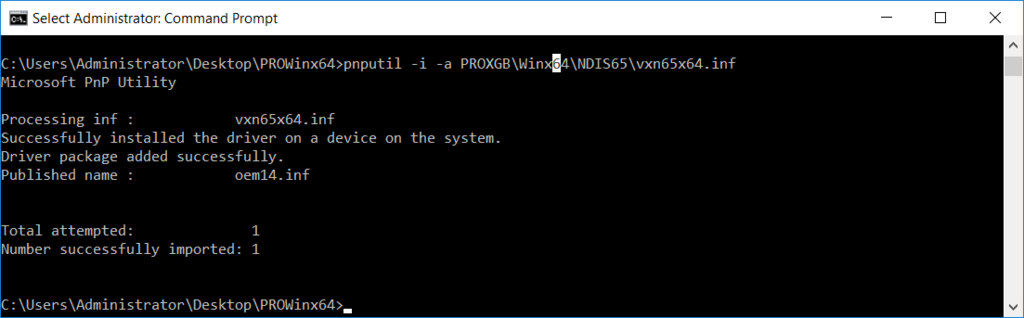

コマンドプロンプトを開き、「ProWinx64.zip」を展開したフォルダに移動して以下のコマンドを実行してINFファイルを追加/インストールします。

pnputil -i -a PROXGB\Winx64\NDIS65\vxn65x64.inf

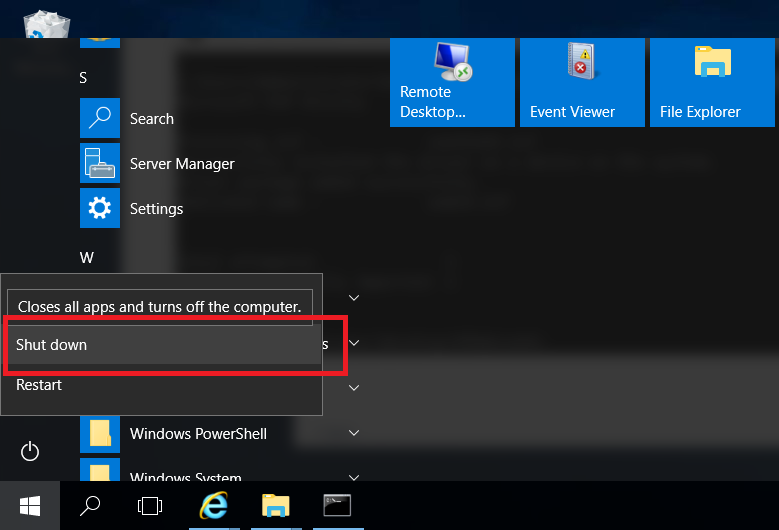

Windows Server をシャットダウンします。

拡張ネットワーキングを有効にする

ローカルのPCなどの別の環境でいかのコマンドを実行して拡張ネットワーキングを有効にします。

Trueと応答されればOKです。

AWSCLIの場合

aws ec2 modify-instance-attribute --instance-id i-xxxxxxxxxxxxxxxx --sriov-net-support simple

PowerShellの場合

Edit-EC2InstanceAttribute -InstanceId i-xxxxxxxxxxxxxxx -SriovNetSupport "simple"

拡張ネットワーキングが有効か確認する

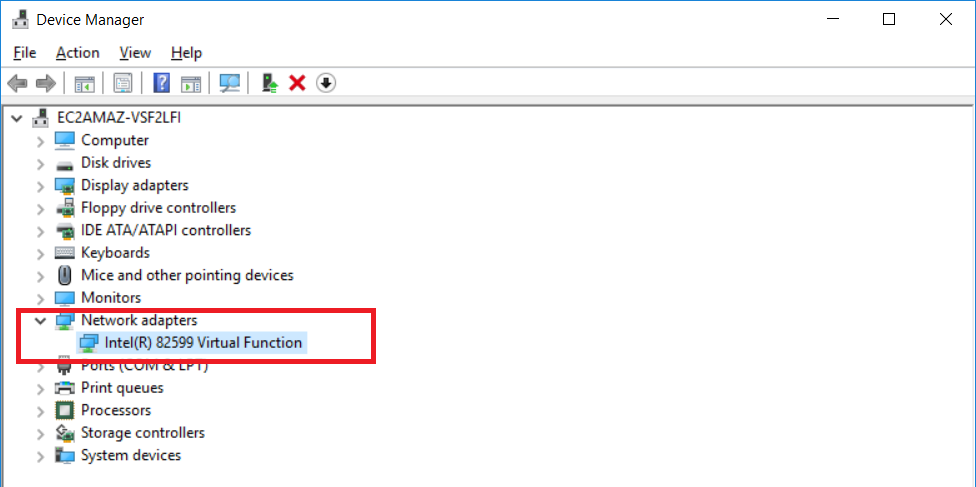

デバイスマネージャーを開き、「ネットワークアダプター」の下に「Intel(R) 82599 Virtual Function」があることを確認します。

インスタンスに拡張ネットワーキングの属性が設定されている確認します。

"Value": "simple"となっていればOKです。

AWSCLIの場合

aws ec2 describe-instance-attribute --instance-id i-xxxxxxxxxxxxxxxx --attribute sriovNetSupport --query 'SriovNetSupport'

PowerShellの場合

Edit-EC2InstanceAttribute -InstanceId i-xxxxxxxxxxxxxxxx -SriovNetSupport "simple"

上記2つがOKであれば拡張ネットワーキングは有効化されています。

まとめ

有効にするだけで通信がはやくなるのでどんどん設定していきましょう!

Amazon Web Services 基礎からのネットワーク&サーバー構築 改訂版

- 作者: 玉川憲,片山暁雄,今井雄太,大澤文孝

- 出版社/メーカー: 日経BP社

- 発売日: 2017/04/13

- メディア: Kindle版

- この商品を含むブログを見る

![AWSエキスパート養成読本[Amazon Web Servicesに最適化されたアーキテクチャを手に入れる! ] (Software Design plus) AWSエキスパート養成読本[Amazon Web Servicesに最適化されたアーキテクチャを手に入れる! ] (Software Design plus)](https://images-fe.ssl-images-amazon.com/images/I/618c9UrF4vL._SL160_.jpg)